Innholdsfortegnelse

Hva er enkel lineær regresjon?

Enkel lineær regresjon brukes til å estimere sammenhengen mellom to kontinuerlige variabler. For eksempel bruker vi enkel lineær regresjon når vi ønsker å vite:

- Hvor sterk sammenheng er mellom to variabler (f.eks. forholdet mellom IQ og lønnsinntekt).

- Verdien av den avhengige variabelen (f.eks. lønnsinntekt) ved en viss verdi av den uavhengige variabelen (f.eks. IQ).

Enkel lineær regresjon er en statistisk metode som brukes til å modellere forholdet mellom to kontinuerlige variabler. Den ene variabelen betraktes som avhengig variabel (responsvariabel), og den andre som uavhengig variabel (forklaringsvariabel eller prediktor). I en enkel lineær regresjon beskriver vi forholdet mellom variabler ved å tilpasse en rett linje (Ya + bx) til de observerte dataene. Regresjonsmodellen gjør det mulig for oss å estimere hvordan en avhengig variabel endres når den eller de uavhengige variablene endres.

Målet med enkel lineær regresjon er å finne den beste rette linjen som beskriver forholdet mellom disse to variablene, slik at man kan bruke denne linjen til å forutsi verdier av den avhengige variabelen basert på den uavhengige variabelen.

Forutsetninger om enkel lineær regresjon

Enkel lineær regresjon er en parametrisk test, noe som betyr at den gjør visse antakelser om dataene. Disse forutsetningene er:

- Varianshomogenitet (homoskedastisitet) : størrelsen på feilen i vår prediksjon endres ikke nevneverdig på tvers av verdiene til den uavhengige variabelen.

- Uavhengighet av observasjoner : observasjonene i datasettet ble samlet inn ved hjelp av statistisk gyldige prøvetakingsmetoder, og det er ingen skjulte sammenhenger mellom observasjoner.

- Normalitet : Dataene følger en normalfordeling.

Lineær regresjon inneholder en ekstra antagelse:

- Lineær sammenheng: Forholdet mellom den uavhengige og avhengige variabelen er lineær : linjen som passer best gjennom datapunktene er en rett linje (i stedet for en kurve eller en slags grupperingsfaktor).

Hvis dataene dine ikke oppfyller forutsetningene om homoskedastisitet eller normalitet, kan du kanskje bruke en ikke-parametrisk test i stedet, for eksempel Spearman-rangtesten.

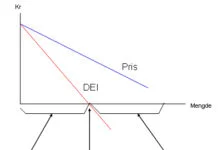

Grunnleggende konsepter

Avhengig Variabel (Y): Dette er variabelen vi ønsker å forutsi eller forklare. Den avhenger av den uavhengige variabelen. F.eks. boligpris.

Uavhengig Variabel (X): Dette er variabelen som brukes til å gjøre forutsigelser. Den antas å påvirke eller forklare den avhengige variabelen. F.eks. boligens areal (kvadratmeter).

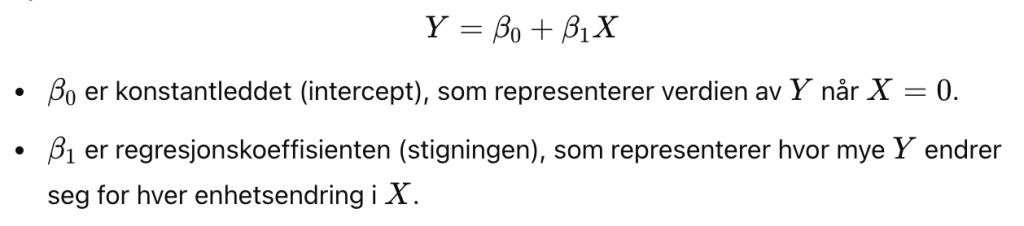

Regresjonslinje: Den lineære regresjonslinjen er den beste tilpassede linjen som minimerer summen av kvadrerte avvik mellom de faktiske verdiene og de predikerte verdiene fra modellen. Linjen har formelen:

Residualer (Feiltermer): Residualene er forskjellen mellom de faktiske verdiene og de predikerte verdiene. I en enkel lineær regresjon prøver vi å minimere summen av kvadrerte residualer (dvs. forskjellen mellom de faktiske og predikerte verdiene) for å finne den best passende linjen.