Lesetid (240 ord/min): 3 minutter

Hva er robots.txt og hvorfor er robots.txt filen viktig?

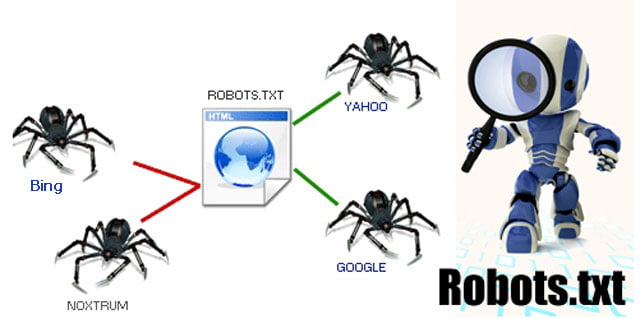

Det finnes to metoder for å fortelle robotene til søkemotorene hva de skal indeksere. Den ene metoden er å lage en “robots.txt” fil som legges på root-katalogen til nettstedet. Så snart roboten kommer til nettstedet vil den spørre etter filen. Eksisterer denne filen vil roboten følge de instruksene som er angitt her.

Filen skal ha et spesielt format, bestående av records. Hver record skal bestå av to felt; en User-agent linje og en eller flere Disallow: linjer.

Lag filen i et program som lager en ren tekst fil. Ikke bruk en HTML editor.

User-agent: User-agent linjen forteller hvilke roboter recorden gjelder for. For eksempel: User-agent: googlebot Du kan også bruke “wildcard”. F.eks. “*” for å angi alle robotene: User-agent: * Disallow:

Den andre delen av record settet inneholder en Disallow: linje som spesifiserer hvilke filer og/eller kataloger som roboten ikke skal indeksere. F.eks., forteller denne instruksen at roboten ikke skal indeksere email.htm: Disallow: email.htm Du kan også spesifisere kataloger: Disallow: /cgi-bin/ Denne linjen gjør at innholdet i katalogen cgi-bin ikke blir indeksert.

Exsempel:

- Denne angivelsen tillater alle roboter å besøke alle filer: User-agent: *Disallow:

- Denne holder alle robotene borte: User-agent: *Disallow: /

- Denne holder robotene borte fra katalogene cgi-bin og images: User-agent: *Disallow: /cgi-bin/Disallow: /images/

- Denne gjør at googlebot ikke får ta i filen cheese.htm: User-agent: googlebotDisallow: cheese.htm

Fortell hvor ditt nettkart (sitemap) er:

- User-agent: *

- Sitemap: http://www.onnet.no/sitemap.xml

Dette forteller robotene til søkemotorene hvor nettkartet ditt ligger Besøk The Web Robots Pages for å lære nærmere hvordan du skriver denne filen for å instruere robotene til å besøke dine sider. Du kan selv teste om denne filen er skrevet korrekt ved å benytte robots.txt analysis tool som er tilgjengelig i Google Webmaster Tools. Den andre metoden er å legge inn “meta-tags” til roboten, såkalte “spider tagg“. Dette er et filter som forteller søkeroboten om websiden skal indekseres og eventuelt hvordan det skal gjøres. Denne metataggen er en fleksibel mulighet for de som ikke kan kontrollere robots.txt filen på webområdet. Den er spesielt nyttig viss du ikke ønsker siden indeksert etter standard metoden ALL (se under)

Robots metatagger har følgende alternativ:

| – utelater du Robots taggen gjelder standarden ALL |

ALL Nettsiden indekseres og søkeroboten følger linker til andre nettsider.

NONE ingenting registreres av søkeroboten

INDEX siden indekseres på søketjenesten.

FOLLOW linker på websiden din følges og indekseres.

NOINDEX siden skal ikke indekseres

NOFOLLOW linker på websiden skal ikke følges/indekseres. Du kan kombinere Robots på følgende vis: INDEX, NOFOLLOW = siden indekseres men linker skal ikke følges/indekseres

NOINDEX, FOLLOW = websiden skal ikke indekseres men linker følges/indekseres. Sider som om oss

, bruker policy

og så videre, inneholder sjelden informasjon folk flest er spesielt interessert i å få vite. Dessuten vil slike sider ofte være linket til fra alle sidene på nettstedet ditt, og følgelig kan søkemotorene komme frem til at de er viktige. Det virker mot sin hensikt.

Note: Mange blokkerer kontakt oss

, men dette skal du være forsiktig med. Hvis folk er ute etter telefonnummeret eller besøksadressen til firmaet ditt, så kan det godt hende de søker etter dette.

Tenk nøye gjennom hvilke sider dine besøkende vil betegne som lite viktige, og bruk robots.txt til å fortelle søkemotorene at du ikke ønsker dem indeksert.

Flere sider med likt innhold er drepen for SEO. Dersom du har mange duplikater på nettstedet ditt, så kan du også bruke robots.txt for å nekte indeksering av disse. Uten å bli for teknisk, så er det slik at mange bruker URL rewriting. Da må du enten sørge for at crawlerne ikke indekserer URL’ene med query string (spørrestreng), eller videresende dem (med 301 redirect) til de omskrevne URL’ene. En enkel robots.txt generator finner du under. Den genererer de vanligste taggene til din robots.txt fil. Robots.txt generator

Du leser nå artikkelserien: Digital markedsføring >> SEO