Lesetid (240 ord/min): 4 minutter

Innholdsfortegnelse

Hva er en hovedkomponentanalyse (PCA)?

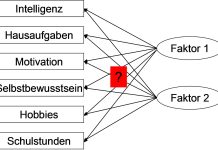

Hovedkomponentanalyse (Principal Component Analysis, PCA) er en multivariat analyse som brukes i en dataanalyse til å redusere dimensjonaliteten i et datasett, samtidig som mest mulig av variansen i dataene bevares.

PCA er spesielt nyttig når man har å gjøre med datasett med mange variabler, hvor det kan være vanskelig å se mønstre eller sammenhenger. Ved å transformere de opprinnelige variablene til et sett av nye, ukorrelerte variabler kalt hovedkomponenter, gjør PCA det mulig å identifisere de viktigste dimensjonene som forklarer variasjonen i dataene.

Hvordan fungerer hovedkomponentanalyse (PCA)?

Standardisering

Før PCA utføres, standardiseres dataene slik at hver variabel har et gjennomsnitt på 0 og en standardavvik på 1. Dette er viktig fordi PCA er følsom for skalaforskjeller mellom variabler.

Eksempel: Hvis man har variabler som inntekt og alder, hvor inntekt er målt i tusenvis og alder i år, vil standardisering bringe disse på en sammenlignbar skala.

Kovariansmatrise eller Korrelasjonsmatrise

PCA starter med å beregne kovariansmatrisen (hvis dataene ikke er standardisert) eller korrelasjonsmatrisen (hvis dataene er standardisert) mellom variablene. Dette viser hvordan variablene er korrelert med hverandre.

Eksempel: Hvis variablene er sterkt korrelert, indikerer det at det kan være redundans i dataene, noe som PCA kan utnytte.

Egenverdier og egenvektorer

PCA beregner deretter egenverdiene og egenvektorene til kovarians- eller korrelasjonsmatrisen. Egenvektorene representerer retningen til de nye aksene (hovedkomponentene), mens egenverdiene indikerer hvor mye varians hver hovedkomponent forklarer.

- Egenvektorer: De retningene i datasettet som maksimalt sprer dataene.

- Egenverdier: Hvor mye av variansen i dataene som forklares av hver egenvektor (hovedkomponent).

Hovedkomponenter

De opprinnelige variablene projiseres på de nye aksene (hovedkomponentene). Den første hovedkomponenten (PC1) er den retningen som forklarer mest varians, den andre hovedkomponenten (PC2) forklarer nest mest varians, og så videre.

Reduksjon av dimensjonalitet: Vanligvis beholder man kun de første få hovedkomponentene som forklarer mesteparten av variansen i dataene, noe som reduserer antall variabler som må analyseres.

Tolkning av resultater

Etter at hovedkomponentene er beregnet, kan de brukes til videre analyser, som visualisering (f.eks. i en scatterplot for de to første hovedkomponentene), klyngeanalyse, eller regresjonsanalyse.

- Ladinger: Egenvektorene (ladingene) viser hvor mye hver original variabel bidrar til hver hovedkomponent. Variabler med høy lading på en komponent bidrar sterkt til denne komponenten.

Eksempel på bruk av PCA

Tenk deg at du har et datasett med økonomiske indikatorer for forskjellige land, inkludert BNP, inflasjon, arbeidsledighet, eksport, import, og gjeld. Alle disse variablene er potensielt korrelerte. Ved å bruke PCA kan du redusere kompleksiteten i datasettet ved å kombinere disse variablene til noen få hovedkomponenter som fanger opp de viktigste mønstrene:

- Første hovedkomponent (PC1): Kan representere en samlet økonomisk styrke, som kombinerer høyt BNP, lav arbeidsledighet, og høy eksport.

- Andre hovedkomponent (PC2): Kan fange opp inflasjon og gjeldsnivå, som kan være relatert til økonomisk stabilitet.

Disse to komponentene kan da brukes til å sammenligne landene på en mer meningsfull måte enn ved å se på hver enkelt variabel separat.

Fordeler med PCA

De største fordelene med PCA er:

- Reduksjon av Dimensjonalitet: PCA gjør det mulig å redusere antall variabler i et datasett, noe som gjør analysen enklere og mer oversiktlig.

- Bevaring av Varians: PCA velger komponenter som fanger opp mesteparten av variansen i dataene, slik at essensiell informasjon ikke går tapt.

- Avdekking av Struktur: PCA kan hjelpe med å identifisere underliggende strukturer og mønstre i dataene som ikke er åpenbare når man ser på variablene individuelt.

Begrensninger med PCA

De største begrensningene med PCA er:

- Tolkning: Hovedkomponentene er lineære kombinasjoner av de opprinnelige variablene, noe som kan gjøre tolkningen av dem mindre intuitiv.

- Lineæritet: PCA forutsetter lineære relasjoner mellom variablene, noe som betyr at det kanskje ikke fungerer godt hvis dataene har komplekse, ikke-lineære mønstre.

- Skalafølsomhet: PCA er følsom for skalaen til de opprinnelige variablene, så standardisering er ofte nødvendig.

- Ingen klar cut-off: Det kan være vanskelig å bestemme hvor mange komponenter man skal beholde, selv om egenverdier og forklart varians gir veiledning.

Bruksområder

PCA har en mengde bruksområder. For eksempel:

- Markedsundersøkelser: Redusere antall spørsmål i en undersøkelse ved å kombinere relaterte spørsmål til hovedkomponenter som representerer bredere begreper som “tilfredshet” eller “lojalitet”.

- Bildetolkning: Brukes i bildedata for å redusere antall piksler som må analyseres, samtidig som hovedinformasjonen bevares.

- Genetisk forskning: Redusere antall genetiske markører ved å kombinere korrelerte markører, noe som forenkler analyser av genetisk variasjon.

Oppsummering

Hovedkomponentanalyse er et kraftig verktøy for å håndtere komplekse datasett med mange variabler, og gir en måte å identifisere de viktigste dimensjonene som forklarer variasjonen i dataene. Det er mye brukt i forskjellige felt som økonomi, biologi, psykologi, og ingeniørfag.

Kilder:

- ChatGPS, “Hovedkomponentanalyse”. Hentet 10.08.24: https://chatgpt.com/